Seit letztem Jahr wurden mehr als 15 Milliarden Bilder mit Hilfe von Text-zu-Bild-Algorithmen erstellt und seit dem Start von DALLE-2 erstellen Menschen durchschnittlich 34 Millionen Bilder pro Tag. KI-Bildgeneratoren – es ist schwierig, eine genaue Anzahl zu nennen, da die Entwicklung und Veröffentlichung solcher Systeme kontinuierlich stattfindet und sich die Landschaft der KI-Technologie ständig verändert. Es gibt zahlreiche KI-Modelle und Algorithmen, die für die Generierung von Bildern verwendet werden können, darunter Generative Adversarial Networks (GANs), Variational Autoencoders (VAEs), und viele weitere.

Bildgenerierung mit KI – Anbieter sind beispielsweise Midjourney StyleGAN und StyleGAN2 von NVIDIA, DALL-E von OpenAI oder BigGAN. Zusätzlich zu diesen bekannteren Modellen gibt es eine Vielzahl von weiteren oder spezialisierten Modellen, die von Forschern und Entwicklern auf der ganzen Welt erstellt wurden. Bei meinen Recherchen und Tests bin ich auf DeepDream gestoßen. Ursprünglich von Google entwickelt, wird DeepDream verwendet, um Bilder zu verfremden und ihnen ein halluzinatorisches Aussehen zu verleihen. Neben DALL-E bzw. Bing Image Creator habe ich mit DeepDream gute Erfahrungen gemacht. Einfach zu bedienen guten und interessante Ergebnisse mit ausreichender Bildqualität.

Meine Ansatz: Die Skizze per KI erzeugen und darauf basierend weiterverarbeiten

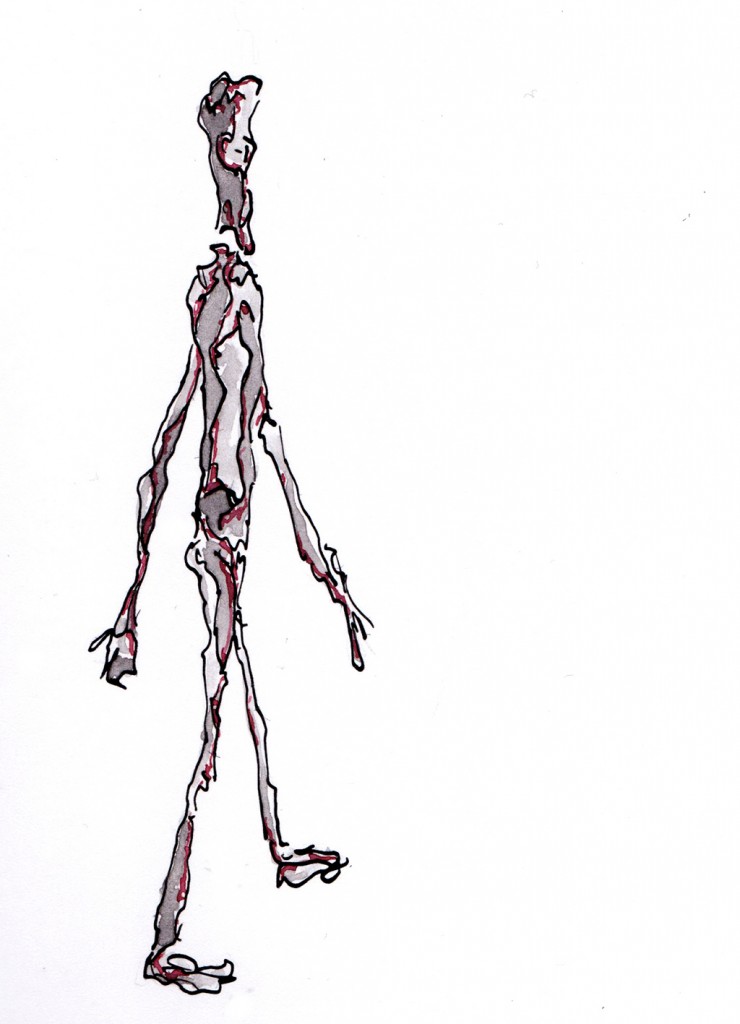

Mein Idee war in erster Linie mit KI-Bildgeneratoren zu experimentieren, um eigene Erfahrungswerte zu sammeln, und zudem eine Bewertung der Entwicklung aus einer kreativen Perspektive. Mir ging und geht es nicht darum, KI für meine kreative Arbeit gezielt zu nutzen, sondern darum, die Potentiale aber auch die Grenzen zu ermitteln. Im aktuellen Experiment wollte ich ein perspektivische Vorlage bzw. Skizze erzeugen für die anschließende grafische Weiterverarbeitung im Gestaltungsprozess. Dabei hatte ich eine klare Vorstellung vom Ergebnis. Der Prompt sollte eine surreale und gleichzeitig minimalistisch Botschaft enthalten, die ich in einer meiner alten Zeichnungen sah (Abb. links) – eine Zeichnung, die ohne Vorlage aus dem Spontanen heraus entstanden war.

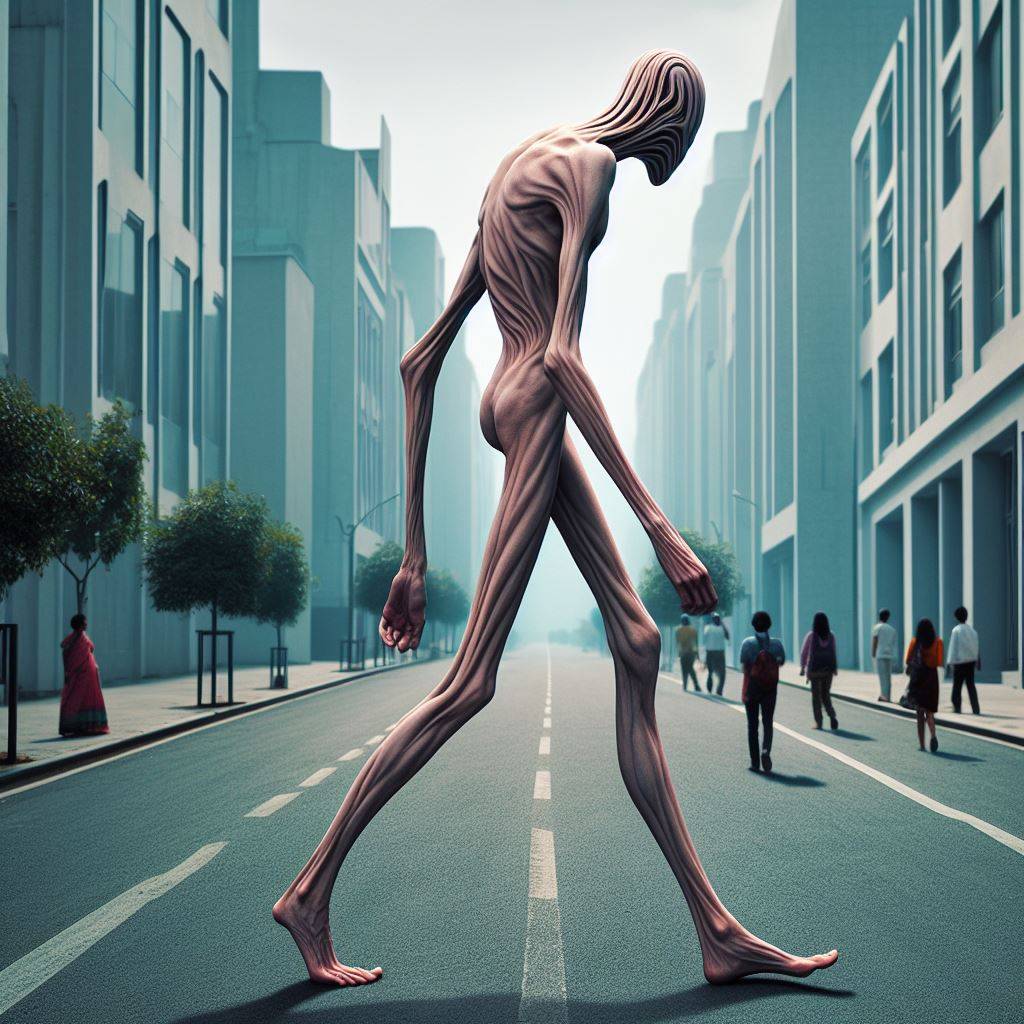

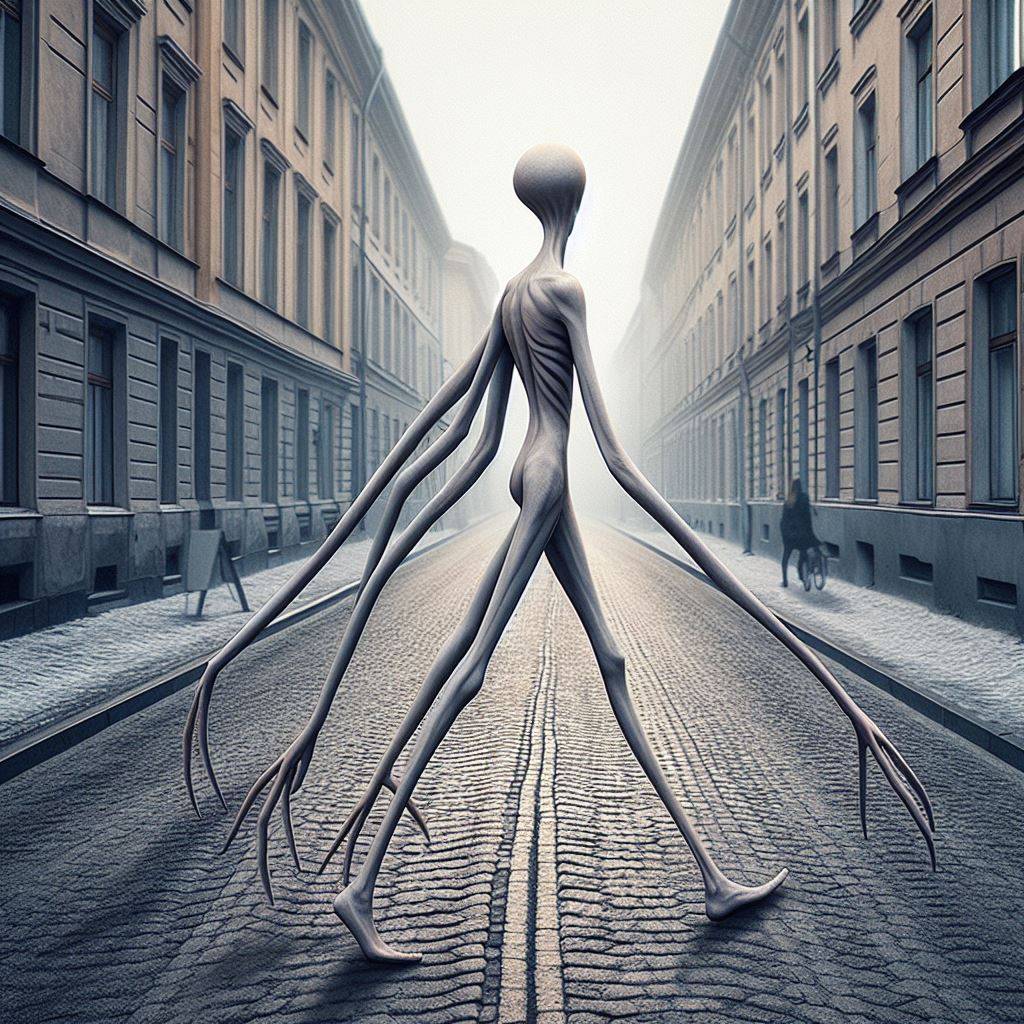

So entstand mein Prompt: Eine Figur mit langen dünnen Armen und Beinen und einem langgezogenen Kopf läuft eine Straße entlang. Die Person ist weder männlich noch weiblich und entfernt sich vom Bildbetrachter.

Im Zuge meiner Experimente wollte ich auch verstehen, wie KI-Bildgeneratoren funktionieren und an welcher Stelle ich Einschränkungen erfahre.

Wie funktionieren KI-Bildgeneratoren

Ein KI-Bildgenerator verwendet in der Regel ein tiefes neuronales Netzwerk, um Bilder zu generieren. Hier ist eine grundlegende Erklärung, wie ein solcher Generator typischerweise funktioniert:

Architektur des neuronalen Netzwerks: Der Bildgenerator basiert oft auf einer bestimmten Architektur wie einem Generative Adversarial Network (GAN), einem Variational Autoencoder (VAE) oder ähnlichen Modellen. Diese Modelle haben verschiedene Schichten von Neuronen, die in bestimmten Mustern miteinander verbunden sind.

Lernprozess: Das neuronale Netzwerk wird mit einer großen Menge von Trainingsdaten gefüttert, typischerweise mit einer Vielzahl von Bildern. Diese Bilder können zufällige Muster enthalten oder spezifische Kategorien von Bildern repräsentieren, je nachdem, wofür der Generator entwickelt wurde.

Generierung neuer Bilder: Nachdem das neuronale Netzwerk trainiert wurde, kann es verwendet werden, um neue Bilder zu generieren. Dies geschieht typischerweise, indem zufällige Vektoren als Eingabe in das Netzwerk eingegeben werden, und das Netzwerk erzeugt dann ein Bild, das auf diesen Eingaben basiert.

Feinabstimmung und Optimierung: Der Prozess der Bildgenerierung kann durch verschiedene Techniken optimiert und verfeinert werden. Dazu gehören beispielsweise die Anpassung der Netzwerkparameter, das Hinzufügen von Regularisierungstechniken zur Vermeidung von Überanpassung und das Feintuning spezifischer Schichten des Netzwerks.

Ausgabe: Das Ergebnis des Generierungsprozesses ist ein Bild, das entweder als statisches Bild oder als Teil einer Sequenz von Bildern ausgegeben werden kann, je nach den Anforderungen der Anwendung.

Vereinfacht gesagt: Es werden Millionen oder Milliarden von Bild-Text-Paaren verwendet, um ein neuronales Netz (im Grunde ein sehr ausgefallener Computeralgorithmus, der dem menschlichen Gehirn nachempfunden ist) darauf zu trainieren, was Dinge sind. Durch die Verarbeitung nahezu unzähliger Bilder lernt es, was Hunde, die Farbe Rot, Stile und alles andere sind.

Der nächste Schritt ist das eigentliche Rendern des von der KI erzeugten Bildes. Die neueste Generation von KI-Bildgeneratoren verwendet dazu einen Prozess namens Diffusion. Im Wesentlichen beginnen sie mit einem zufälligen Rauschfeld und verarbeiten es dann in einer Reihe von Schritten so, dass es ihrer Interpretation der Eingabeaufforderung entspricht. Es ist, als würde man in einen wolkenverhangenen Himmel schauen, eine Wolke finden, die wie ein Hund aussieht, und dann mit den Fingern schnippen, um sie immer hundeähnlicher zu machen.

Gestalterisches Experimentieren mit Künstlicher Intelligenz

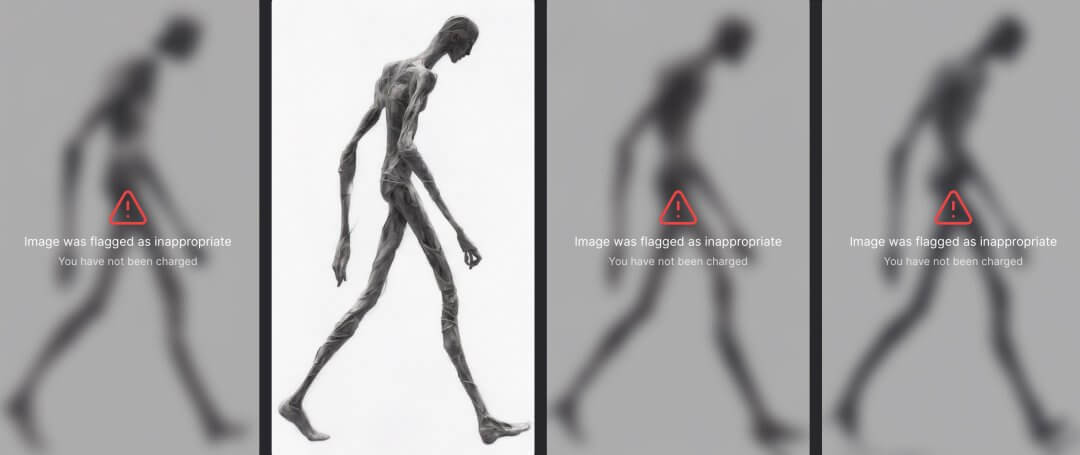

Ich habe meinen Prompt an DALL-E 2, Adobe Firefly, DreamStudio (Stable Diffusion) sowie Bing Image Creator (DALL-E 3) und Deep Dream Generator übergeben. Die Ergebnisse lagen teilweise sehr eng beieinander (siehe Abb. unten), wobei ich im Falle von DreamStudio über einen Aspekt gestolpert bin, der eine der Grenzen von KI-Bildgeneratoren unterstreicht. Image was flagged as inappropriate hieß es plötzlich. Die KI hatte entschieden, dass drei der erzeugten Bilder unangemessen sind. Ich bezweifle zwar, dass die drei weichgezeichneten Versionen sich groß von der akzeptierten Version unterscheiden, aber eine Sache wird deutlich: KI-Bildgeneratoren schränken teilweise ein, wenn es um kontroverse oder kritische Gestaltung geht. Der Algorithmus prüft jeden Prompt mit Blick auf die Content Policy und entscheidet, ob ein Bild generiert werden darf oder nicht. Ob man das jetzt als eine Form von Zensur bezeichnen kann, sei jedem selbst überlassen. Wenn ein Mensch Stift und Papier oder andere Werzeuge anwendet, um etwas zu visualisieren, gibt es nur die eigenen Vorstellungskraft als Grenze. Kreative Freiheit, Provokation oder andere Aspekte – der Mensch kann mit entsprechenden Werkzeugen, seinem Können und seiner Vorstellungskraft jede Art von Kreation realisieren – sei sie noch so kontrovers oder verstörend. Die KI-Plattformen schränken dies ein, unterscheiden sich aber auch in dem, was sie zulassen. DreamStudio hat den Prompt A gloomy portrait of Vladimir Putin with falling bombs in the background zugelassen, DALL-E nicht.

Meine Herangehensweise bei der grafischen Umsetzung

Ich wende gerne einen Ansatz an, der das Digitale und das Analoge kombiniert, wobei ich mit verschiedenen Zwischenstadien experimentiere – ab und an erzeugt der Zufall unerwartet eine spannende Version einer Grafik, die ich dann im Prozess weiterverarbeite.

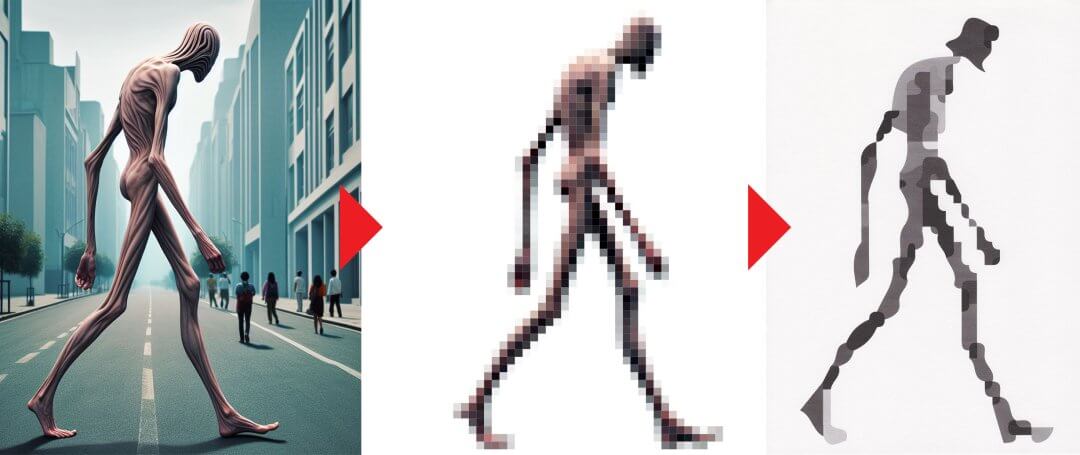

Prompt: Im ersten Schritt habe ich die KI-Bildgeneratoren mit meinem Prompt gefüttert und verschiedene Versionen erzeugen lassen. Die Ergebnisse der einzelnen Plattformen ähnelten sich tatsächlich. Natürlich wirken sie an einigen Stellen verstörend, aber mir ging es vorwiegend um die Körperhaltung ansich; der Stil hatte keinerlei Relevanz.

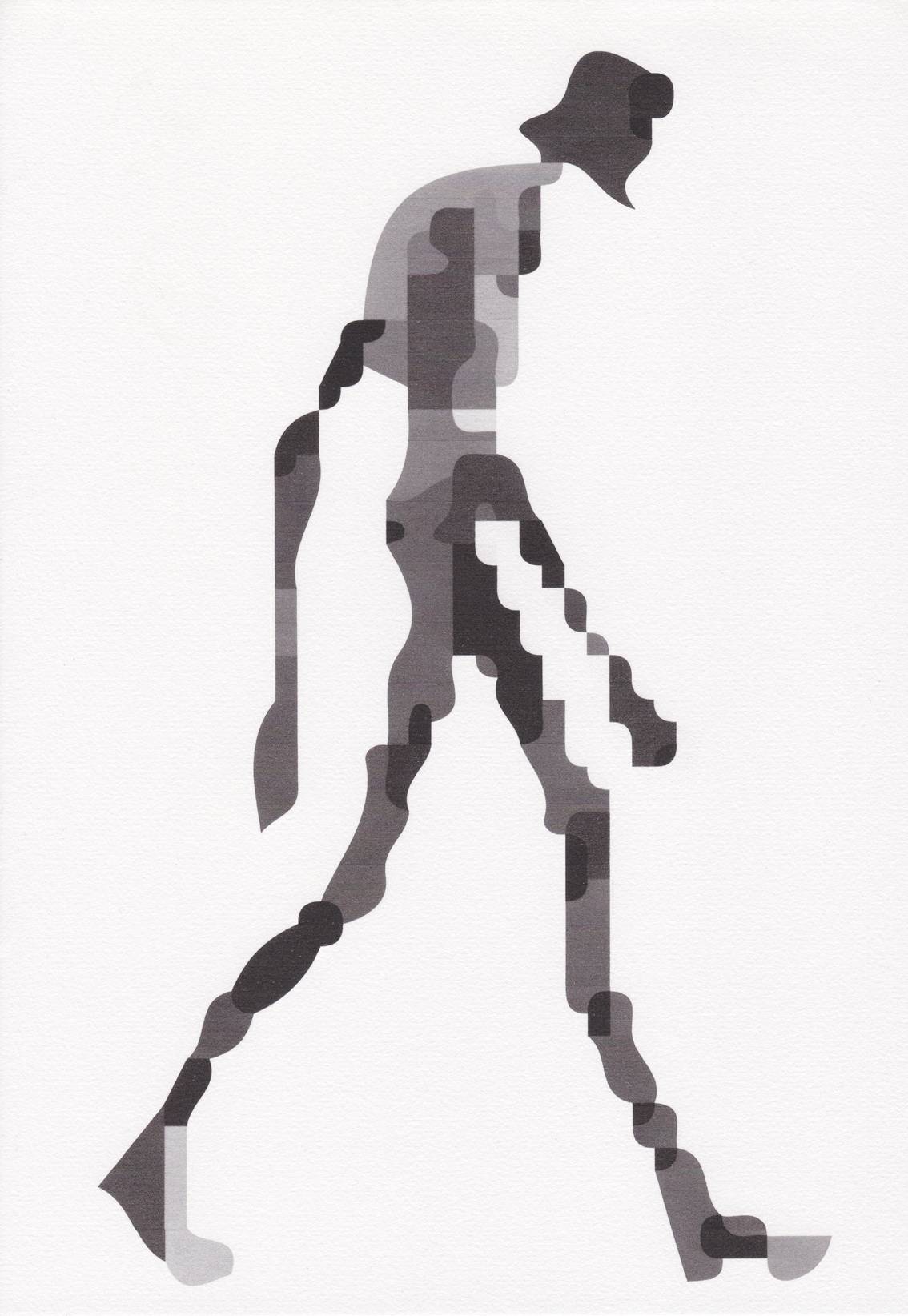

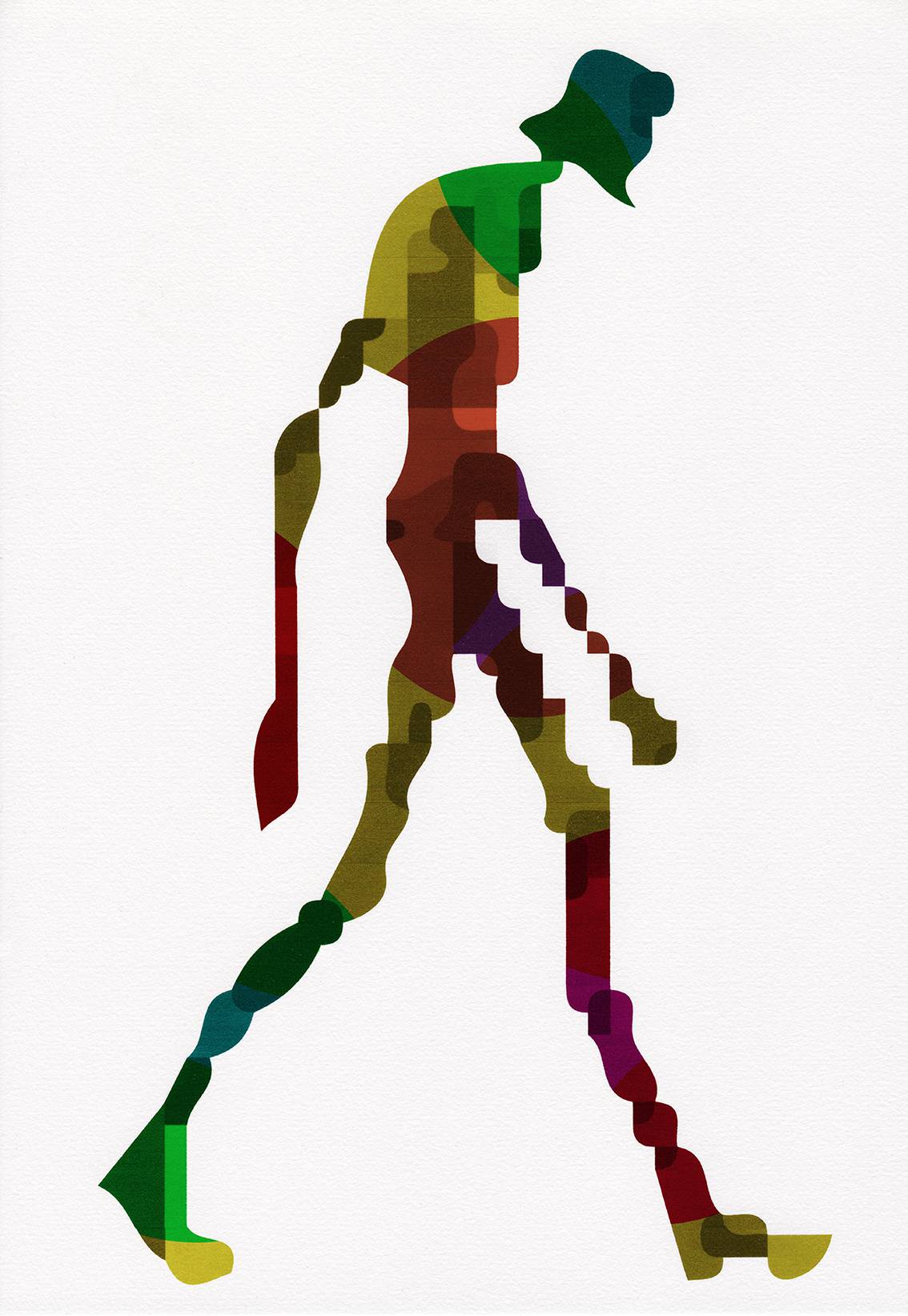

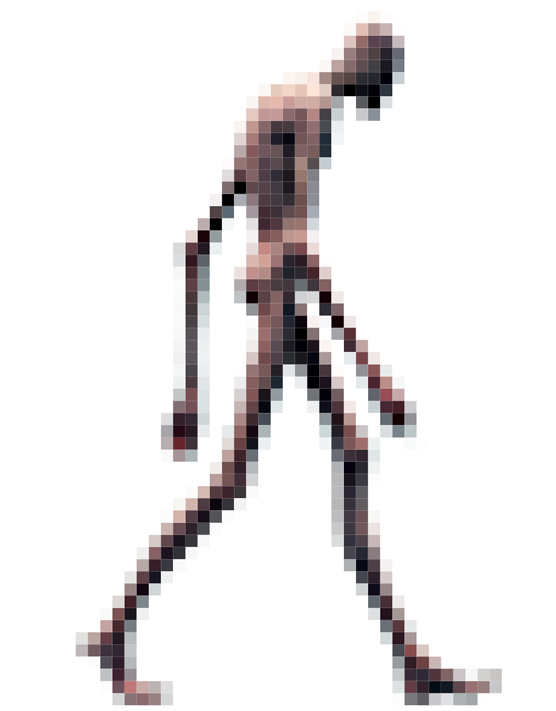

Pixel-Bild: Dann habe ich einen Schritt angewendet, bei dem ich die Einstellungen der Auflösung eines Bildes missbrauche. Konkret heißt das, dass ich ein Bild in einem Grafikprogramm lade, dann ändere ich die aktuelle Auflösung von 72 dpi auf 10 dpi. Das bedeutet, dass pro Inch 10 Dots / Pixel erzeugt werden, keine 72. Ich verpixel das Bild bewusst. Dann zoome ich am Bildschirm heran und mache einen Screenshot von dieser Darstellung. Das Ergebnis sieht dann wie folgt aus.

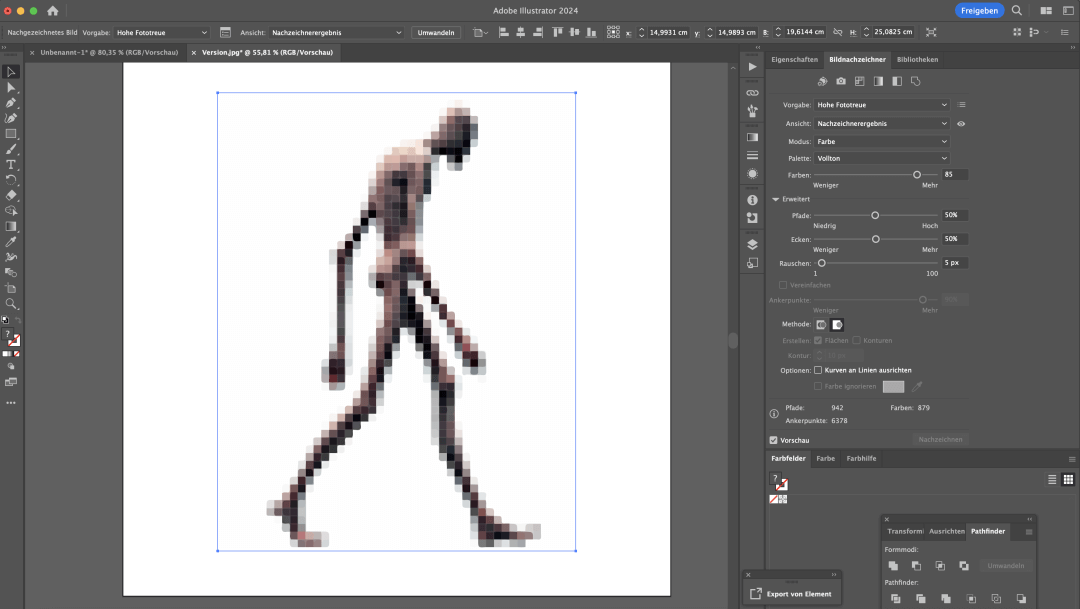

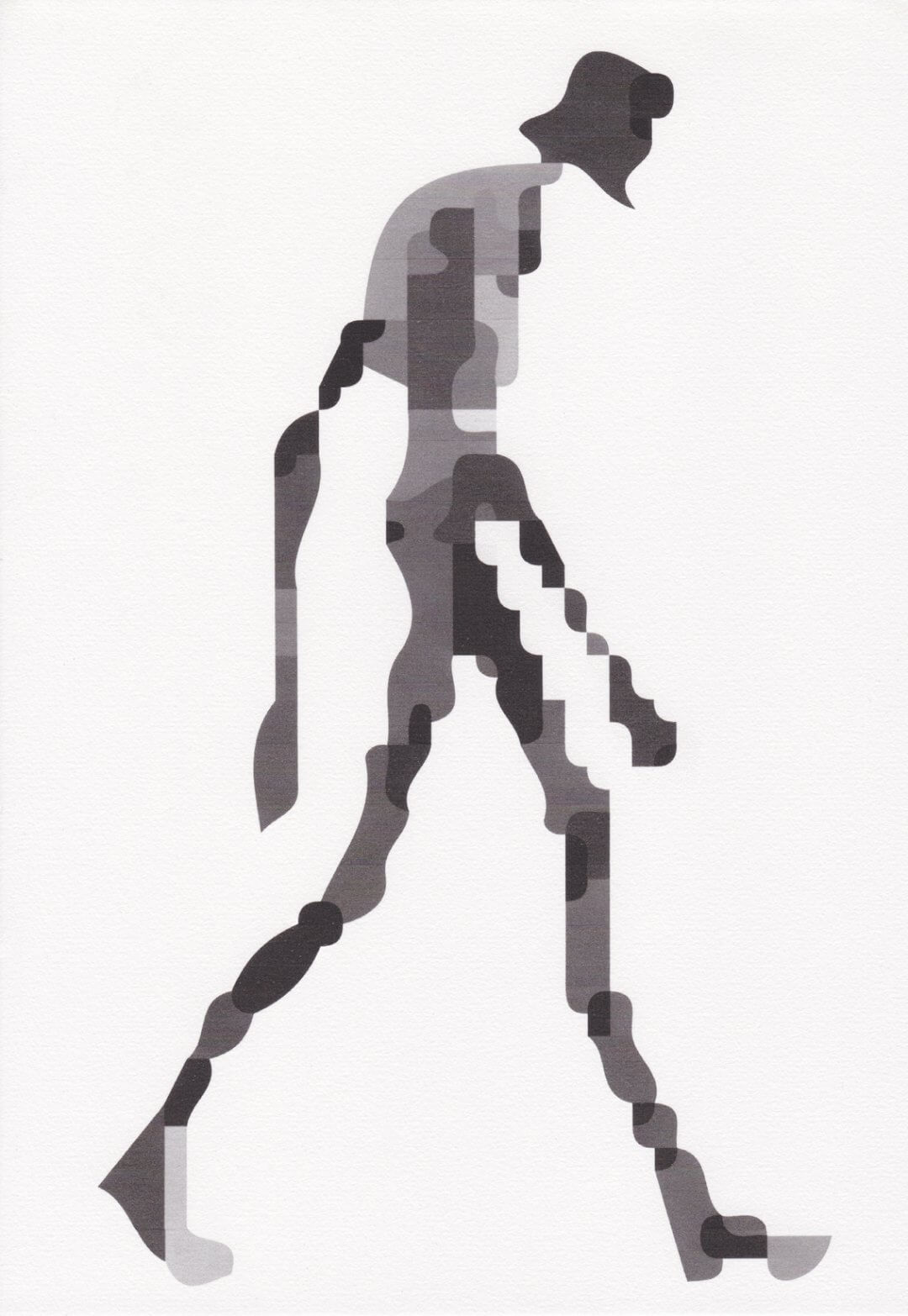

Vektorisierung: Der nächste Schritt ist ein Grafikprozess aus Adobe Illustrator. Ich lade den Screenshot als Bild in Adobe Illustrator, einem vektorbasierenden Grafikprogramm, und vektorisiere das Bild. Illustrator erfasst alle Flächen mit dem Werkzeug Bildnachzeichner und erzeugt Vektoren aus den Pixeln. Über die Pfadeinstellungen kann ich das Ergebnis beeinflussen.

Analoges Verarbeiten: Der Vorteil der Vektorisierung ist, dass aus der eher geringen Auflösung des KI-Bildes eine beliebig skalierbare Vektorgrafik wird. Diese drucke ich anschließend Schwarz-Weiss aus und nutze die Kopierfunktion meines Druckers. Ich kopiere den Ausdruck auf ein gutes Zeichenpapier, wobei der Kopiervorgang eigentlich wie ein Druck mit reduzierter Qualität ist. Über diesen Weg erhalte ich eine Körnung und eine Struktur, bei dem das Analoge des Papiers hervorgehoben wird. Diese Version scanne ich dann ein und bereinige sie minimal.

Das Ergebnis aus dem gestalterischen Prozess

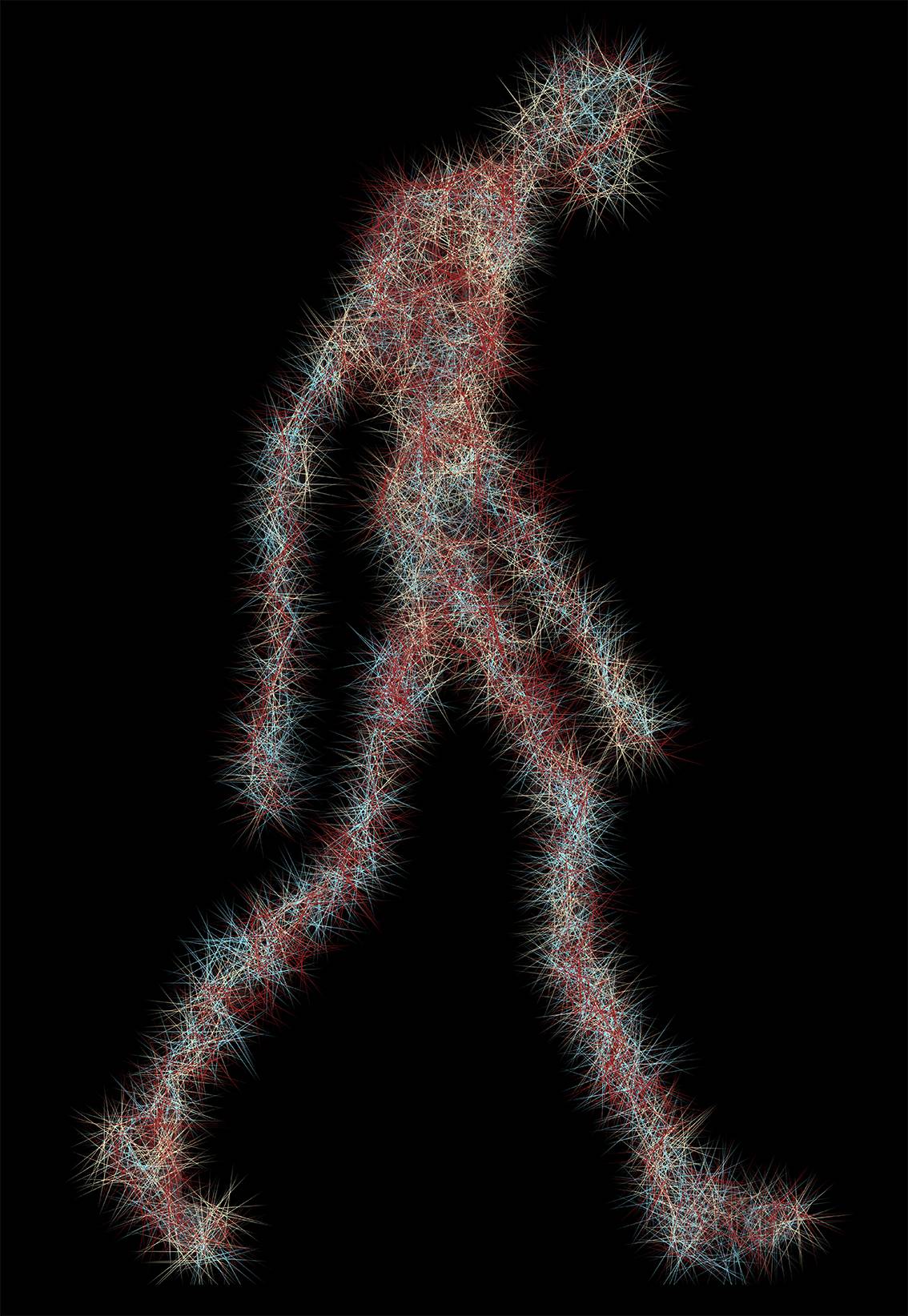

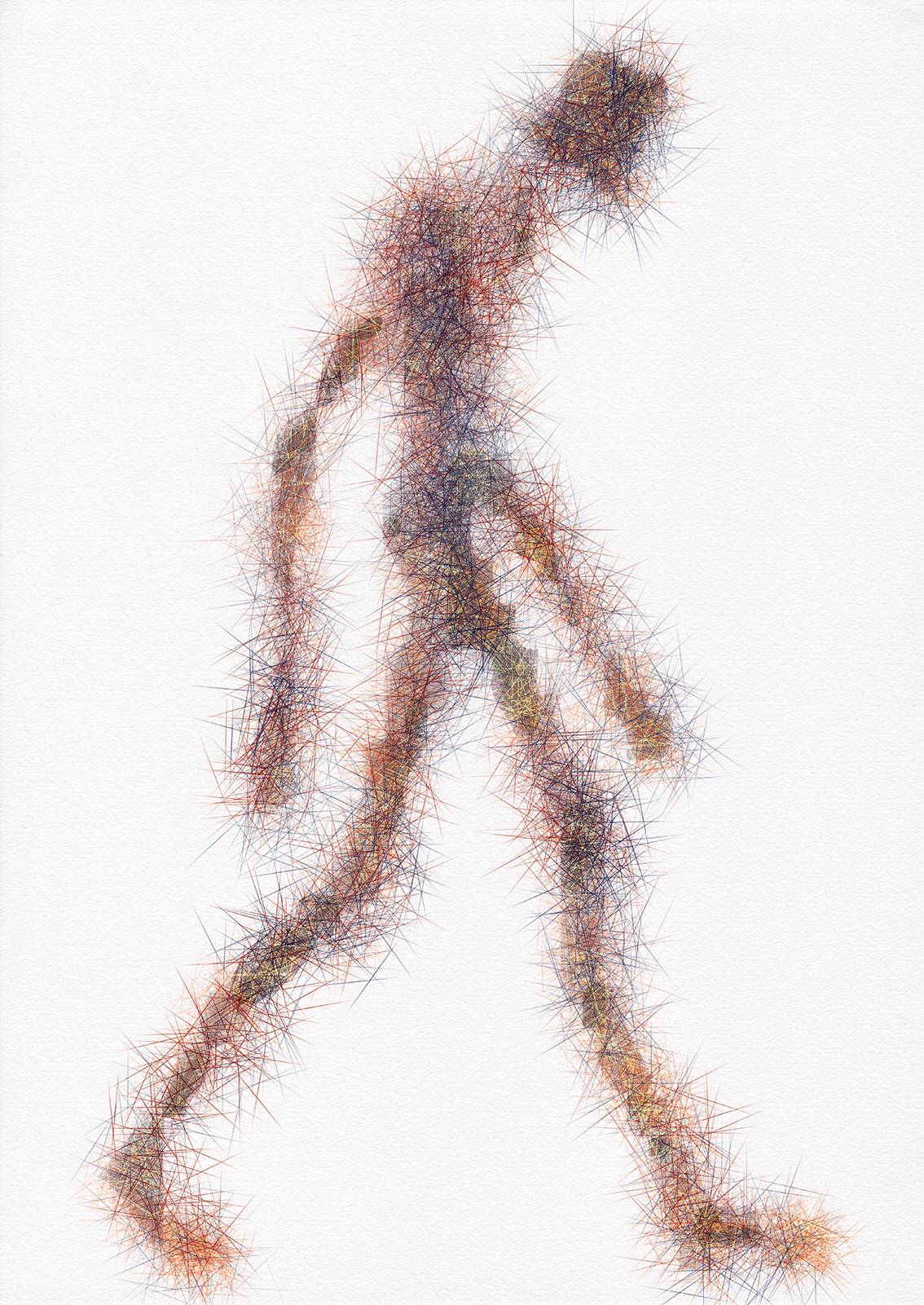

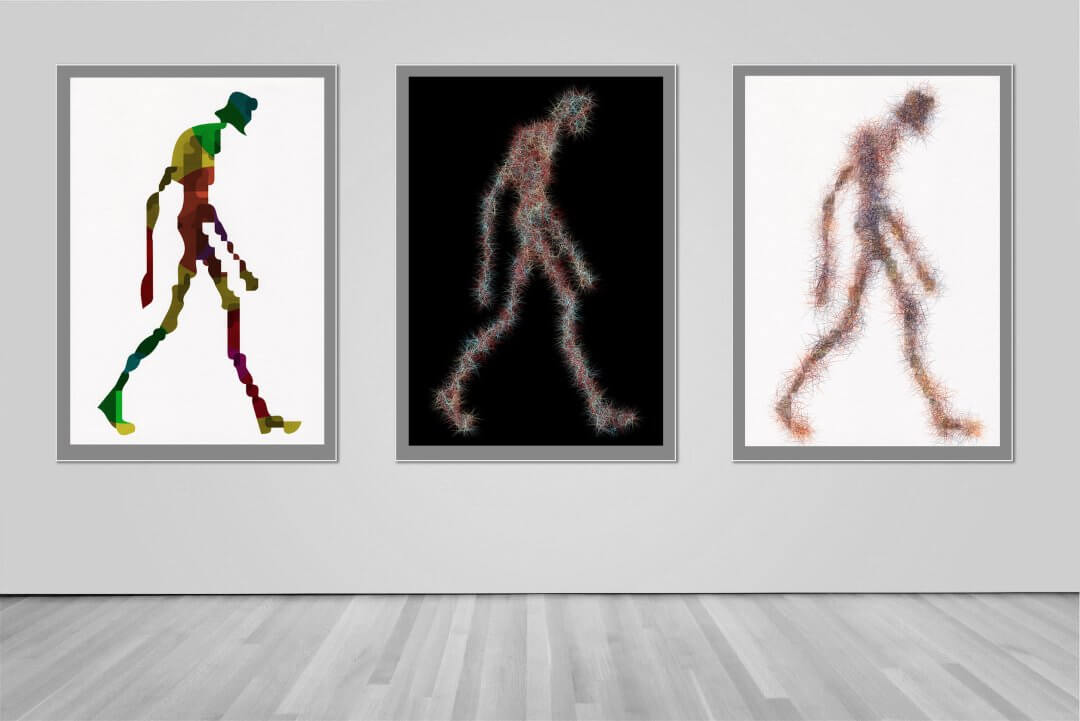

Experimentieren: Der fertige Scan wird dann in Adobe Photoshop geladen und freigestellt (Hintergrund entfernen), damit ich nur die Figur als Element nutzen kann, die Struktur des Papiers aber in der Figur enthalten bleibt. Die Weiterverarbeitung erfolgte dann in der App Procreate auf dem iPad Pro. Hier habe ich mit digitalem Pinsel (Brush) und dem Übereinanderlegen von Ebenen Versionen erzeugt, die ich als Endergebnis sehe.

Für mich ist das der erste Prozess, da ich in einem zweiten Prozess die Ergebnisse als Vorlage für eine analoge Skizze und Zeichnung nutzen will. Was kann ich aus dem, was jetzt vorliegt, machen und inwieweit hat die KI mir am Schluss geholfen, etwas Neues zu erschaffen?

Die besten KI-Bild-Generatoren

Mit dieser Überschrift werben so viele Seiten und zeigen dann in ihren Prompt-Beispielen gefühlt die gleichen Bilder. Tiere, Portraits und Landschaften. Schwächen haben alle Plattformen zur Bildgenerierung mit KI, seien es:

- Unförmige Hände mit zu langen oder kurzen, dicken oder dünnen, fehlenden oder zusätzlichen Fingern.

- Zu perfekte glatte Haut ohne Falten oder Unregelmäßigkeiten.

- Unnatürliche Belichtung oder falsche Schatten.

- Zu kontraststarke Bildstimmung und unruige Strukturen

Es gibt meines Erachtens nicht die besten KI-Bildgeneratoren. Je nach Vorstellung und Zweck muss man selber testen und die Ergebnisse für sich bewerten. Wer kein Abo abschließen will, muss Einschränkungen hinnehmen. Das oft bereitgestellte Bildformat 1:1 reicht für Social Media aus, nicht aber für Webseiten-Header oder gar für Druckerzeugnisse. Adobe Firefly bietet ohne Kosten verschiedene Formate inklusive 16:9 und eine gute bis sehr gute Auflösung. Auch DALL-E und Midjourney bieten gute Qualität und verschiedene Formate, allerdings nur im Abo.

Mein Tipp: Das Kombinieren aus erzeugten Bildern und die Bearbeitung in einem Grafikprogramm. So erhält man ein nutzbares und individuelles Ergebnis, das Mehrwert hat. Warum nicht eine Collage aus einzelnen Elementen und folglich eine auffällige Komposition.

Fazit Bildgenerierung mit KI

Künstliche Intelligenz und KI-Bildgeneratoren – die Meinungen gehen auseinander und gerade die Kreativwelt steht der Entwicklung eher skeptisch gegenüber. Wer als Grafikdesigner, Illustrator, Musiker oder Autor sein Geld verdient, der macht sich Sorgen um seine Zukunft und um seine Einnahmen. Meine Meinung ist, dass die menschliche kreative Leistung und professionelle Kreativarbeit immer ihren Stellenwert haben wird. Trotzdem muss man sich mit der Materie auseinandersetzen – frei nach dem Motto „Kenne deinen Feind“.

Eine Sache empfinde ich als extrem störend: Bei fast allen Anbietern zur Bildgenerierung mit KI kommt man ohne eine Registrierung nicht weit und es stehen nur eine begrenzte Menge Prompts kostenfrei zur Verfügung – dann heißt es Warten oder Credits einkaufen bzw. ein Abo abschließen. Midjourney weist nach einer Registrierung direkt darauf hin, dass wegen hoher Auslastung die Nutzung nur noch mit einem Abo möglich ist. OpenAI verlangt ebenso ein Abo für die Nutzung von DALL-E 3, bietet aber noch kostenlosen Zugriff auf DALL-E 2, was meines Erachtens für Experimente ausreicht. DALL-E 3 kann man über Bing Image Designer nutzen.

Meine Empfehlung: Ausprobieren und je nach Anforderung genau überlegen, ob Prompten das benötigte Ergebnis liefert. Ein(e) Illustrator:in ist ein Profi, der saubere, individuelle und auf den Auftrag abgestimmte optimale Ergebnisse liefert.